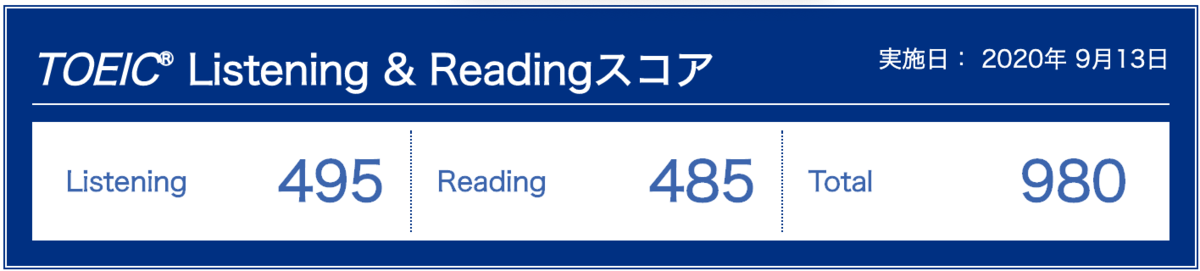

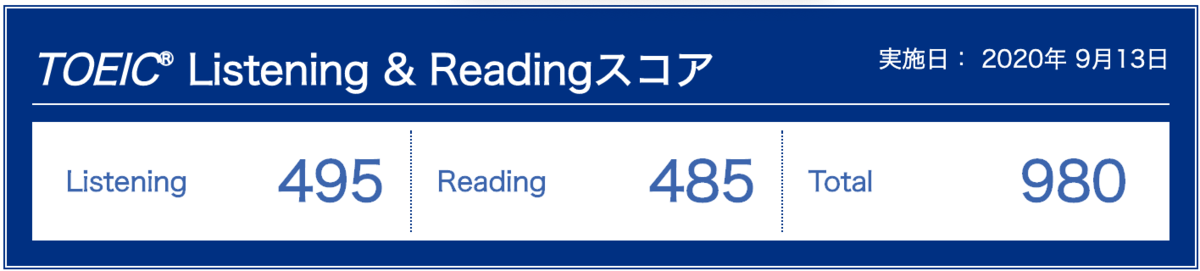

2020年9月13日に行われた第252回 TOEIC® Listening & Reading 公開テストにて 980 点を取得しました。他の方の参考になればと思い、使用した参考書や行った勉強法を共有します。

TL;DR

- 「目標点をとる上で自分に足りない能力はなにか」「しっかり負荷がかかる学習が行えているか」を意識しながら学習を行うことが一番大事

- DUO3.0とCore1900で基礎的な英単語をみっちり鍛えることでTOEIC対策に耐える基礎力をつけましょう。時間をかければ新しい単語や表現の意味を思い出せる状態でやめないこと。英会話レッスン等と組み合わせて覚えた単語を自在に使える状態まで持っていくことが重要。

- 速読速聴・英単語 TOEIC TEST GLOBAL 900 はTOEICの問題に似た文章で英単語を覚えていく形式であり、TOEIC風の文章に慣れながら単語を覚えていけるため強くおすすめできる。

- Part2とPart5は対策が効きやすいパートであり、対策のコスパが非常に高い。

- 公式模試を解き終わったら本番より難しめの模試を解くのがおすすめ。私は精選模試2のリスニング・リーディングを使用

具体的な学習内容以前の話

使った参考書やWebサービス等の解説の前に先に書いておきたいのですが、「この記事に書いてあったからこの本をやる」「この記事に書いてあったから参考書をN回繰り返す」というスタンスで勉強に取り組んでいるうちは個人的にはどこかでTOEICの点数が頭打ちになってしまう可能性が高いんじゃないかと思っています。

あくまでこの記事で書かれていることは参考程度にとどめ、「目標を達するために自分に今足りない能力はなにか」「どのようなトレーニングを行うと目標に近づけるか」「今の学習方法はしっかり負荷がかかる方法になっているか(特にシャドウイング)」を常に自問自答し、学習法を決めていくことをおすすめします。

具体的な学習内容

英語学習スタート前の状態

- 小中学校では英語が比較的得意だった

- 高校時代にDUO3.0を使ったことがある

- 大学受験をしなかったので大学受験のための英語学習は未経験

- TOEIC受験経験なし

TOEIC用の勉強開始前(2019.06 ~ 2020.5)

この頃は特に資格試験を受けるつもりはなく、「英語のドキュメントや海外カンファレンスの動画を理解できるのってかっこいいな」という単純な動機で学習をはじめました。

当初の動機は仕事で活かすことでしたが次第にレアジョブのレッスン内でいかにうまく話せるかということに主眼が移っていきました。

今から考えるとすぐにTOEIC対策に取り掛からず、DUO3.0やCore1900および英会話レッスンで基礎的な英語力をじっくり高めたことが、後のTOEICでの高得点につながったのではないかと思います。

英会話レッスン(レアジョブ)

この時期に英語学習の中心になっていたのはレアジョブというサービスでの1日25分の英会話レッスンでした。

レアジョブのレッスンでは、最初は日常会話用の教材を使っていたのですが、レッスンに慣れた後はDaily News Articleという教材を使っていました。この教材は毎日配信される記事を題材にディスカッションするというもので、記事の内容が面白く毎回レアジョブの先生と議論するのが楽しかったのを覚えています。

ただレッスンを惰性で受けるだけでは受動的な学習になってしまい効果が薄いと感じたため、瞬間英作文の練習やDUO3.0/Core1900の音読・シャドウイングを行った直後にレッスンを受けるようにしていました。これにより、覚えたばかりの能動的に使うことができない語彙を自然と背伸びして使うことになったため、結果として能動語彙が増え、能動語彙が増えると英会話のレッスンが楽しくなるという良いループが生まれていました。

瞬間英作文

英会話のレッスンを受け始めてすぐに、言いたいことを文章の形で伝えることができないという壁にぶつかったため瞬間英作文の練習を行いました。

中学校で習うような英文を文字通り瞬間的に英作文する学習法です。

上記2冊の参考書でしばらくトレーニングを行うことで、簡単な英文であれば一瞬で口から出せるようになりました。

ある段階で瞬間英作文は卒業して単語帳のシャドウイングに練習の中心を移したのですが、TOEIC用の勉強を始めた後も特定の文法が苦手(使役動詞等)だと感じたら瞬間英作文風に作文して練習するなど、文法を能動的に使える状態に持っていく方法としては学習期間を通して活用していました。

単語帳

よく使われる表現を覚え英会話で役立てるためにDUO3.0とCore1900という2つの単語帳を使用しました。この頃はTOEICの受験は考えていませんでした。

DUO3.0

DUO3.0は1600個の重要単語と熟語1000個を560本の基本例文を通して覚えていく、いわゆる短文型の単語帳です。Natto smells awful but tastes terrific. のような短文の中に覚える必要がある単語が散りばめられており、例文を暗記するだけで重要な単語を効率的に覚えられます。短文自体も退屈にならないように工夫がされており、ドジなボブの話などクスッと笑ってしまうような短文も多いです。

別売りで基礎用と復習用の2種類のCDが発売されているのですが、CDのあるなしで学習効率が段違いなのでかならずCDを入手し耳も使って覚えていくと良いと思います。基本的には復習用のみ買えばシャドウイング等の練習には十分です。

レアジョブのレッスン前の準備体操として毎日1冊の1/4程度をシャドウイングし、土日など時間がある時に音読をするという感じで1ヶ月程度使用していました。高校時代に学習教材として使っていて内容を半分程度覚えていた状態だったため、完全に初見の方はもう少し長めにやっても良いかもしれません。

速読速聴・英単語 Core1900

速読速聴・英単語は単語帳の中で個人的に最もおすすめできるシリーズです。

このシリーズはいわゆる"文脈型"単語帳であり覚える必要がある単語が散りばめられた 120 語程度の文章を使って単語を学習していきます。長文を使って学習していくので、シャドウイングや音読の教材として使うことで新しい単語を覚えることにとどまらず、リスニングや長文読解等すべての英語力をバランス良く伸ばせる教材だと感じています。

Core1900はPart1とPart2に分かれていて、Part1は120語程度のニュース記事とその中に登場した見出し語がまとまっているいわゆる文脈型単語帳の形式、Part2はDUOのような短文型単語帳形式です。特にPart1の文章には「光害の問題」など読み物としても普通に面白い記事が多くおすすめできます。

新しい記事に取り組む際には以下のようにしていました。

- 英文を一度も読んでいない状態で音声を3回程度聞き、耳だけで英文を理解する練習をする

- 英文を読んで聞き取れなかった部分・新しい単語を確認

- 3回音読

- シャドウイングを数回(1.2 倍速まで次第にスピードアップ)

この本で出た表現は、2ヶ月程度この本音読・シャドウイングをした直後に英会話レッスンを受けることを繰り返すことで、一部の難しい表現を除いて英会話の中で自然に使える状態を目指してトレーニングを行っていました。これにより基礎的な単語の運用力がかなり鍛えられました。

TOEIC 勉強開始(2020.05 ~ 2020.07)

レアジョブのレッスン内で自信がついたので、力試しを兼ねてTOEICを受けてみようと学習を開始しました。

この時期に最も重視したのは以下です。

- TOEIC用単語の習得

- TOEICのリーディングパートより少し難しい記事の多読によるリーディングスピードの向上

- Part2対策(対策が行いやすいため早めにスタート)

- Part5対策(対策が行いやすいため早めにスタート)

速読速聴・英単語 TOEIC TEST GLOBAL 900

TOEIC用単語の習得には主に速読速聴・英単語 TOEIC TEST GLOBAL 900を用いました。

TOEICのPart3,4,6,7のような文章を使って単語を覚えていく文脈型単語帳です。使用法はCore1900のときとほぼ同様で、音読・シャドウイングを繰り返し、直後に英会話レッスンを受けることでなるべく新しく学んだ語彙を能動的に使える状態を目指して練習しました。

個人的にはこの本で飽きるまでTOEICっぽい文章を音読・シャドウイングしたことでリスニング力とリーディング速度の両方に効いたと感じており、TOEIC対策単語帳として強くおすすめできます。

金のフレーズ

GLOBAL 900の補助としてTOEIC L & R TEST 出る単特急 金のフレーズ(通称金フレ)を使用しました。こちらは語彙に抜けがないことやTOEIC特有の語義等をチェックするために使いました。ただ、個人的にフレーズで覚えていくスタイルが肌に合わなかったので2周程度でやめてしまいました。

Japan Timesの記事を読む

TOEIC のリーディングパートよりやや難しい文章でリーディング速度向上トレーニングをするため、Japan Timesの記事を空き時間で読むようにしていました。

新しい記事を読む際には以下のように読んでいました

- 時間を計測しながら読む

- 意味がわからなくなったり文章構造が掴めなくなってもなるべく戻り読みをしない

- 英単語の意味は調べない

- どのあたりに何が書いてあったかなんとなく理解できる程度の理解度で読めるのが理想(Part7のような問題を解くために必要な情報が文章のどのあたりに書かれていたかぼんやりわかるぐらい)

- 読み終わったら単語数を時間で割り、おおよその WPM を確認する(私の場合はWPM160ぐらいで理解度を最大にするため、WPMを元に読み方を調整していました)

- 同じ記事を時間をかけて文章構造を正確に把握することを意識しながらもう一度読む。英単語は記事の意味を理解するのに支障がある場合だけ調べる

Part5 対策

Part5 の対策としては、まず Evergreen(旧 Forest)を問題集を合わせて一通り通読しました。

後から考えるとこの本は重箱の隅をつつくような文法事項の解説も多く、通読するよりも辞書的に使ったほうが効率的だったかもしれません。

その後、Evergreen(旧 Forest)を 7 割程度頭に入れた状態で以下の問題集を使って対策を行いました。

多いようですが、Part5は明らかに対策が効きやすいパートであると感じていたため、対策を重点的に行いました。

Part2 対策

Part2 の対策としては、以下の問題集を用いて問題演習および聞けなかった問題の復習を繰り返しました。

Part2 の勉強では必然的にたくさんの短い文を聞くことになるため、自分がリスニングする上で苦手な音や表現を自覚することができました。

以下の参考書もレビューが良いので Part2 が苦手な方は追加で取り組んでも良いかもしれません

受験直前期(2020.07 ~ 2020.09)

直前期には以下の模試をひたすら解いていました。

精選模試は本番より難しいという評判なのですが、難しい問題を高地トレーニングとして解き、また一度解いた難しい問題を使ってリスニングの練習等を行ったことで、本番ではかなり余裕を持って解答できました。

模試を解くときには以下のようにしていました。

- 新しい模試を解く・採点

- 間違えた問題・わからなかった単語の確認

- Part2 で聞けなかった問題をリストアップ・数回聴く

- Part3,4 を1.3倍速でシャドウイング(何日かに分けて 3~5 周)

- 1.3倍速にしてリスニングパートを再度解く(リーディングパートは解かなかった)

1.3倍速でリスニングパートを再度解いたのは、先読み等の解答プロセスに集中した練習を行うためでした。模試を解く中で先読みが苦手だと感じていましたが、一度解いた問題を1.3倍速再生しながら先読みの練習をすることで、普通の速度で問題を解く時に余裕を持って先読みが行えるようになりました。

模試の素点

個人的に模試を解いている際に、「模試の素点が何点ぐらいなら本番で目標点に達するか」がわからなくてとても不安だったため、せめてもの目安になればと私が模試を解いた際の素点を晒しておきます。

| |

L |

R |

備考 |

| 公式模試 6 T1 |

91 |

92 |

|

| 公式模試 6 T2 |

94 |

97 |

|

| 精選模試 2 T1 |

77 |

93 |

精選模試の洗礼で大きく L が下がる |

| 精選模試 2 T2 |

93 |

91 |

|

| 精選模試 2 T3 |

88 |

93 |

|

| 精選模試 2 T4 |

89 |

94 |

|

| 精選模試 2 T5 |

89 |

98 |

|

| 公式模試 5 T1 |

98 |

94 |

|

| 公式模試 5 T2 |

98 |

97 |

|

| 公式模試 4 T1 |

97 |

97 |

|

| 公式模試 4 T2 |

99 |

94 |

|

精選模試には本番での予想得点の換算表が載っているのですが、私個人の話で言うと本番では換算表の点数より+20~30点ぐらいの点数が出たのでこちらも参考として。

まとめ

ここに紹介したような対策でTOEICの本番では980点を獲得することができました。誰かのお役に立てば幸いです。